AI幾乎讀取了互聯(lián)網(wǎng)上的所有內(nèi)容,但仍渴望獲得更多數(shù)據(jù)。為此,開發(fā)人員必須尋找變通之道,。

得益于神經(jīng)網(wǎng)絡(luò)規(guī)模的擴大以及海量數(shù)據(jù)的訓(xùn)練,,人工智能(AI)在過去10年間突飛猛進,。“做大做強”的策略,,在構(gòu)建大型語言模型(LLM)上取得了顯著成果,,ChatGPT就是一個典型的例子。

然而,,《自然》《麻省理工科技評論》等多家雜志網(wǎng)站指出,AI擴展正逼近極限,。一方面,,AI“吞噬”著越來越多的能源;另一方面,滋養(yǎng)無數(shù)模型成長的傳統(tǒng)數(shù)據(jù)集,,正被LLM開發(fā)人員過度開墾。

訓(xùn)練數(shù)據(jù)即將遭遇的瓶頸已悄然浮現(xiàn),。有研究機構(gòu)預(yù)測,到2028年左右,,用于訓(xùn)練AI模型的數(shù)據(jù)集典型規(guī)模將達到公共在線文本總估計量的規(guī)模,。換句話說,,AI可能會在大約4年內(nèi)耗盡訓(xùn)練數(shù)據(jù),。與此同時,,數(shù)據(jù)所有者(如報紙出版商)開始打擊對其內(nèi)容的濫用行為,,進一步收緊了訪問權(quán)限,這將引發(fā)“數(shù)據(jù)共享”規(guī)模上的危機,。為此,開發(fā)人員必須尋找變通之道,。

數(shù)據(jù)集供需失衡

過去10年間,,LLM的發(fā)展顯示出了對數(shù)據(jù)的巨大需求。自2020年以來,,用于訓(xùn)練LLM的“標(biāo)記”(或單詞)數(shù)量已增長100倍,,從數(shù)百億增加到數(shù)萬億。一個常見的數(shù)據(jù)集RedPajama,,包含數(shù)萬億個單詞。這些數(shù)據(jù)會被一些公司或研究人員抓取和清洗,,成為訓(xùn)練LLM的定制數(shù)據(jù)集,。

然而,可用互聯(lián)網(wǎng)內(nèi)容的增長速度出乎意料的緩慢,。據(jù)估計,,其年增長率不到10%,而AI訓(xùn)練數(shù)據(jù)集的大小每年增長超過一倍,。預(yù)測顯示,,這兩條曲線將在2028年左右交匯,。

與此同時,,內(nèi)容供應(yīng)商越來越多地加入軟件代碼或修改條款,,阻止爬蟲及AI抓取其數(shù)據(jù),。在這些內(nèi)容中,被明確標(biāo)記為限制爬蟲訪問的數(shù)量,,從2023年的不足3%猛增到了2024年的20%至33%之間,。

當(dāng)前,圍繞AI訓(xùn)練中數(shù)據(jù)使用的合法性,,試圖為數(shù)據(jù)提供商爭取應(yīng)有賠償?shù)亩嗥鹪V訟正在進行。2023年12月,,《紐約時報》向OpenAI及其合作伙伴微軟提起了訴訟,指控其侵犯了版權(quán),;今年4月,紐約市Alden全球資本旗下的8家報紙聯(lián)合發(fā)起了一起類似的訴訟,。對此,OpenAI表示,,《紐約時報》的訴訟“毫無根據(jù)”,。

若法院最終站在內(nèi)容提供商一方,,支持其獲得經(jīng)濟賠償,那么對于AI開發(fā)人員,,尤其是那些資金緊張的學(xué)者而言,獲取所需數(shù)據(jù)無疑將變得更加艱難,。

新方法有待印證

數(shù)據(jù)匱乏對AI的傳統(tǒng)擴展策略構(gòu)成了潛在挑戰(zhàn)。

尋找更多數(shù)據(jù)的一個途徑是收集非公開數(shù)據(jù),,如社交媒體消息或視頻文字記錄。然而,,這種做法的合法性尚存爭議,。

一些公司選擇使用自己的數(shù)據(jù)來訓(xùn)練AI模型,如meta利用虛擬現(xiàn)實頭顯收集的音頻和圖像進行訓(xùn)練,。但各公司政策不同,,包括Zoom在內(nèi)的一些公司則明確表示不會使用客戶內(nèi)容訓(xùn)練AI,。

另一種選擇可能是專注于快速增長的專業(yè)數(shù)據(jù)集,,如天文學(xué)或基因組學(xué)數(shù)據(jù),,但其對訓(xùn)練LLM的可用性和實用性尚不清楚,。

如果AI接受除文本之外的多種類型的數(shù)據(jù)訓(xùn)練,,可能會為豐富數(shù)據(jù)的涌入打開閘門,。meta首席AI科學(xué)家勒丘恩強調(diào),,人類通過觀察物體而“吸收”的數(shù)據(jù)遠超用于訓(xùn)練LLM的數(shù)據(jù)量,,機器人形態(tài)的AI系統(tǒng)或許能從中獲取經(jīng)驗,。

此外,,制造數(shù)據(jù)也是解決之道,。一些AI公司付費讓人們生成訓(xùn)練內(nèi)容,或使用AI生成的合成數(shù)據(jù)來訓(xùn)練AI,。這已成為一個潛在的巨大數(shù)據(jù)源,。然而,,合成數(shù)據(jù)也存在問題,如遞歸循環(huán)可能鞏固錯誤,、放大誤解,并降低學(xué)習(xí)質(zhì)量,。

小模型更專更精

另一種策略是摒棄模型“越大越好”的開發(fā)觀念。一些開發(fā)者已在追求更高效,、專注于單一任務(wù)的小型語言模型,。這些模型需要更精細、更專業(yè)的數(shù)據(jù)以及更好的訓(xùn)練技術(shù),。

12月5日,,OpenAI發(fā)布了新的OpenAI o1模型,。盡管該公司未透露模型的規(guī)?;蛴?xùn)練數(shù)據(jù)集大小,,但o1采用了新方法:在強化學(xué)習(xí)上投入更多時間,,讓模型對每個回答進行更深入的思考。這標(biāo)志著一種轉(zhuǎn)變,,即從依賴大規(guī)模數(shù)據(jù)集進行預(yù)訓(xùn)練,,轉(zhuǎn)向更注重訓(xùn)練和推理,。

當(dāng)前,,LLM可能已飽覽互聯(lián)網(wǎng)大部分內(nèi)容,或許無需更多數(shù)據(jù)即可變得更智能,。美國斯坦福大學(xué)一項研究表明,模型從多次讀取給定數(shù)據(jù)集中學(xué)到的內(nèi)容,,與從相同數(shù)量的唯一數(shù)據(jù)中學(xué)習(xí)到的內(nèi)容一樣豐富。

合成數(shù)據(jù),、專門數(shù)據(jù)集,、多次讀取和自我反思等因素的結(jié)合,或?qū)⒐餐苿覣I的進一步飛躍,。

(編輯:月兒)

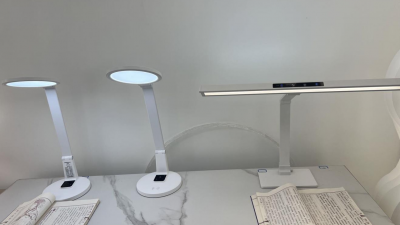

“護眼臺燈”亂象調(diào)查

“護眼臺燈”亂象調(diào)查 AI賬號成起號新套路 多手段繞過“AI打標(biāo)”背后有哪些隱患,?

AI賬號成起號新套路 多手段繞過“AI打標(biāo)”背后有哪些隱患,? 救命的醫(yī)療設(shè)備,,如何淪為個人提款機?

救命的醫(yī)療設(shè)備,,如何淪為個人提款機? 原價上千元“貴婦霜”網(wǎng)店賣不到百元

原價上千元“貴婦霜”網(wǎng)店賣不到百元